Vincenzo Vespri, Professore di Analisi matematica dell’Università di Firenze

Il 21 aprile 2021 la Commissione Europea ha presentato il suo pacchetto sull’IA. Il 9 dicembre 2023 il Parlamento europeo ha raggiunto un accordo provvisorio sul cosiddetto AI EU Act, anche se il negoziato tra le istituzioni europee è attualmente in corso e sono diversi i punti del testo ancora da definire. Dai documenti ufficiali della comunità europea si può prevedere che il regolamento sarà sottoposto all’approvazione dei rappresentanti degli Stati membri (Coreper) nei primi mesi del 2024; ciò accadrà certamente prima delle elezioni europee del prossimo giugno quando una probabile diversa composizione del parlamento europeo non appoggerebbe questa visione molto restrittiva sull’uso dell’AI. Trattandosi di un regolamento, queste norme si applicheranno in modo uniforme e diretto in tutti gli Stati membri, senza che ci sia necessità di leggi di recepimento nazionali. Tuttavia, le norme dell’AI EU Act non entrerebbero in vigore immediatamente: è previsto un periodo cuscinetto di almeno 24 mesi prima della sua applicazione.

“L’AI EU Act detta le regole per lo sviluppo, l’immissione sul mercato e l’utilizzo di sistemi di intelligenza artificiale nell’Unione europea con l’obiettivo di rafforzare la ricerca e la capacità industriale, garantendo allo stesso tempo la sicurezza e i diritti fondamentali.”

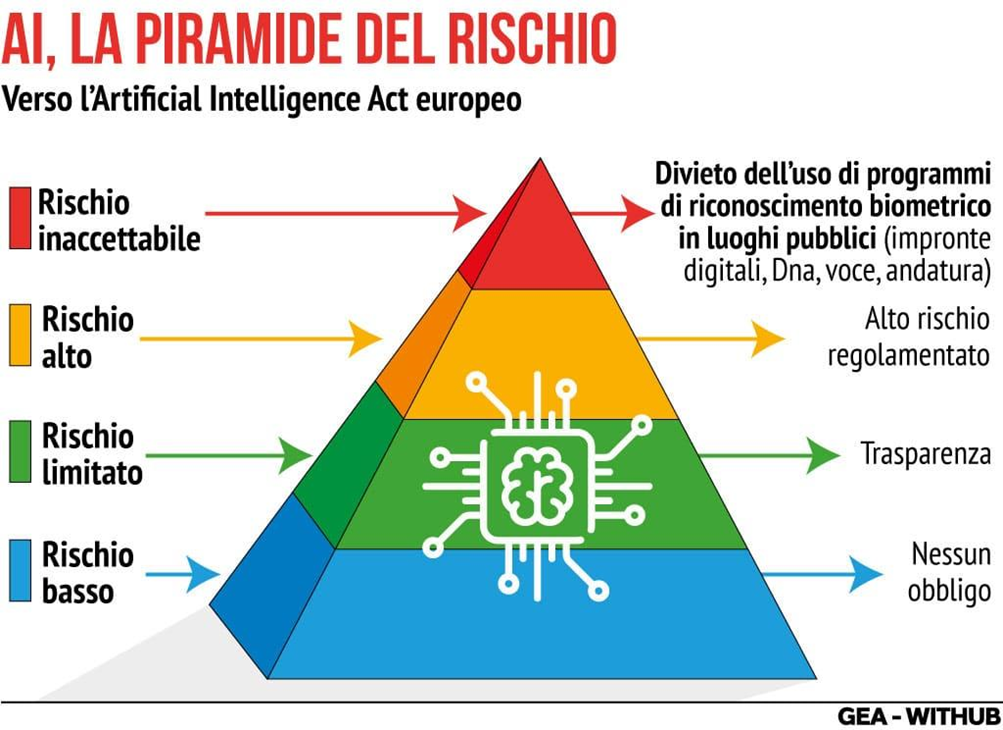

L’approccio scelto si basa sulla cosiddetta piramide dei rischi dell’AI. E’ stata definita unascala di rischio per regolamentare le applicazioni di intelligenza artificialesu quattro livelli: “… dal livello minimo (come videogiochi e filtri anti-spam che usano l’AI), al livello limitato (come chatbot), fino al livello alto (assegnazione di punteggi a esami scolastici e professionali, smistamento dei curriculum, valutazione dell’affidabilità delle prove in tribunale, chirurgia assistita da robot) per concludersi con il livello ritenuto inaccettabile (tutto ciò che rappresenta una “chiara minaccia” che invade la sfera dei diritti inalienabili dell’essere umano) che deve essere assolutamente proibito …” Tra le cose assolutamente vietate ci sono i sistemi che utilizzano tecniche subliminali/ manipolative o sono utilizzati per il social scoring (come quello descritto nell’episodio Nosedive di Black Mirror o del Social Credit cinese). “… La partita degli emendamenti si sta giocando sull’inclusione o meno in questa lista anche di sistemi di identificazione biometrica in spazi accessibili al pubblico che possono utilizzare caratteristiche sensibili (sesso, etnia, cittadinanza, religione, orientamento politico) e dai social media o dalle telecamere a circuito chiuso per creare database di riconoscimento facciale……” Ma si discute anche di sistemi di polizia predittivi stile Minority Report Criminal Minds (basati su profili o comportamenti criminali passati) e software di riconoscimento delle emozioni anche negli aeroporti, nei posti di frontiera, nei luoghi di lavoro e nelle scuole. Il compromesso sembra quello di escludere la proibizione negli impieghi ad uso personale ed in altri specifici settori, quale ad esempio quello militare.

Per i sistemi ad alto rischio vengono imposti requisiti e obblighi ad hoc, mentre per quelli a rischio limitato, come i sistemi di deep fake, si prevedono specifiche prescrizioni per garantire la trasparenza come ad esempio dichiarare esplicitamente che i contenuti siano stati generati da un sistema di AI e non da un essere umano.

L’Intelligenza Artificiale di tipo generativo, che non era stata considerata (perché non esisteva ancora) nel documento del 2021, è stata considerata nell’AI EU Act:

- si prevedono degli obblighi per i fornitori di modelli di base quali una governance dei dati che rispetti la privacy dei cittadini

- si prevede il massimo rispetto per l’impatto ambientale e la registrazione dei modelli in una banca dati europea prima dell’immissione sul mercato.

Questi modelli saranno sviluppati in modo da evitare generazione di contenuti illeciti o discriminanti.

Nelle intenzioni della Commissione, le norme dell’AI EU Act riguarderanno tutti gli operatori della catena di valore dell’intelligenza artificiale. A partire da chi sviluppa o fa sviluppare sistemi di AI per immetterli sul mercato o porli in servizio con il proprio nome o marchio. Il regolamento ha inoltre una portata extraterritoriale: sono inclusi nel campo di applicazione dello stesso importatori e distributori, nonché gli operatori che utilizzano un sistema di AI, sotto la propria autorità.

La proposta della Commissione, per le violazioni più gravi, stabilisce sanzioni pecuniarie fino a un massimo di 30-40 milioni di euro o fino al 6 % – 7% del fatturato mondiale totale annuo dell’esercizio precedente, se superiore. Sono inoltre previste sanzioni per chi fornisca informazioni inesatte, incomplete o fuorvianti ad autorità ed organismi competenti.

Se da un punto di vista etico non si può che approvare l’operato della Commissione nell’evitare eccessi nell’utilizzo dell’AI che potrebbero portare a mondi distopici come quelli descritti in film e romanzi di fantascienza, molti dubbi sorgono se si considerano gli aspetti tecnologici e industriali considerando che, al momento, pochissimi paesi fuori dall’UE si sono dichiarati pronti a seguire una linea così restrittiva. In tal senso sarebbe opportuno un AI ACT a livello mondiale, non solo a livello europeo.

Da un punto di vista tecnologico, l’obiezione naturale è che siamo di fronte ad una tecnologia in rapida evoluzione. Il regolamento emanato potrebbe diventare obsoleto in pochissimi anni. Basti pensare che se l’AI EU Act fosse stato diffuso due anni fa, non avrebbe tenuto conto della rivoluzione dell’AI generativa.

Per quanto riguarda gli aspetti industriali ed economici, è fin troppo facile prevedere che l’avvento dell’AI porterà a una rivoluzione di portata nettamente superiore a quella industriale del 1700. Sarà vitale per l’Europa essere parte attiva di questa rivoluzione e non solo essere ridotta a un mercato che la subisce. Attualmente il mondo sta diventando per lo meno bipolare: suddiviso fra paesi occidentali (capitanati dagli USA) e i BRICS. L’AI è sicuramente una infrastruttura strategica, per cui l’extraterritorialità richiesta dall’UE potrebbe essere imposta solo per i paesi occidentali. Inoltre, al di là di questa considerazione geopolitica, ritengo che sia utile tenere presente come l’AI sia un bene immateriale; non è chiaro quindi come potrebbero essere aumentati i controlli necessari per implementare l’AI EU Act a livello extraterritoriale. Infine, in Occidente ci sono solo quattro aziende (Open AI, Microsoft, Google e Amazon) che hanno quasi l’oligopolio nell’AI e sono tutte e quattro americane. Sembra molto difficile che l’UE abbia la forza di imporre reali sanzioni a questi quattro colossi su cui si basa l’economia statunitense. Inoltre, in Occidente, oltre che in USA, industrie che operano in AI esistono solo in UK (che non fa più parte della Comunità Europea), in Francia, in Giappone, in Corea del Sud e Taiwan. Ora regole così restrittive (anche se moralmente giuste) non applicate dagli altri paesi occidentali (almeno in questa forma così estrema) spingerebbero le aziende AI a scegliere come loro base i paesi che richiedono la regolamentazione meno stringente, non quindi i paesi dell’UE. Si deve notare che nell’AI EU Act sono previste misure per incoraggiare l’uso dell’AI in Europa, ma questo tipo di misure, fino ad adesso, quando applicati in altri campi, non hanno portato a risultati concreti: l’UE, nonostante il roboante proclama della dichiarazione di Lisbona, sta sempre più faticando a non essere obsoleta tecnologicamente. Ad esempio, i vaccini contro il Covid19 sono stati prodotti in tutti i paesi leader fuorché in UE e la leadership delle automobili a trazione elettrica appartiene ormai saldamente alla Cina e agli USA (Tesla).

Possiamo rischiare di rinunciare ad avere un’azienda europea di AI per perseguire il pensiero arrogante di essere noi a dettare la linea di comportamento, come se l’Europa contasse ancora qualcosa nello scacchiere mondiale?